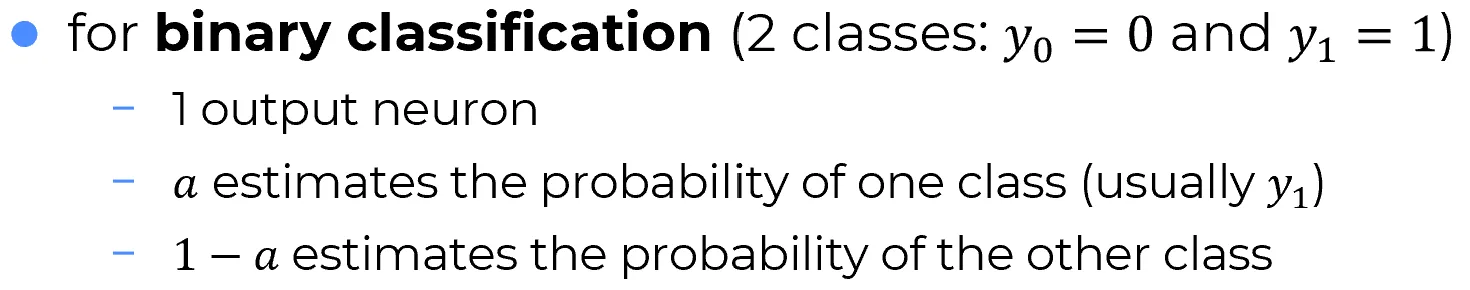

In a binary classification scenario, the output can represent two distinct categories, such as dogs and cats.

Tuttavia, per permetterne la gestione all’interno del modello, tali categorie vengono codificate in modo dicotomico, associando i valori e rispettivamente a ciascuna delle due classi.

Per effettuare una classificazione binaria è sufficiente un singolo neurone di uscita della rete neurale.

Questo perché l’uscita del neurone può essere interpretata come la probabilità di appartenenza a una delle due classi. Dalla teoria della probabilità, sappiamo che in un problema binario,

la probabilità dell’altra classe è semplicemente il complemento a uno di quella stimata:

P(\text{classe 0}) = 1 - P(\text{classe 1}) \quad \text{e viceversa}

Specializing for Binary Classification

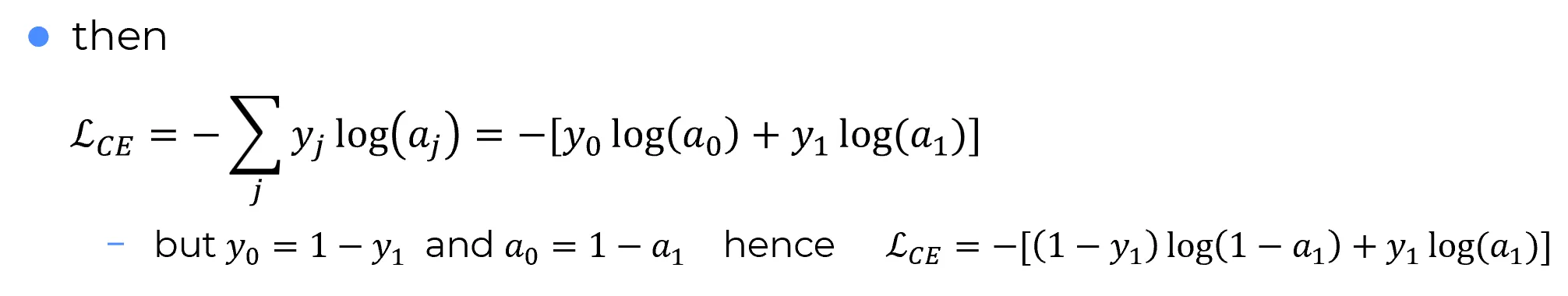

Formally, the cross-entropy loss function is still written as:

Warning

In classificazione binaria si ha un solo neurone di uscita. Tuttavia, nella formula esplicita della loss in tale contesto, compaiono comunque due termini: uno relativo alla classe positiva e uno alla classe negativa.

🎯 Perché compaiono due termini?

Anche se esiste un solo neurone che produce l’output , per modellare entrambe le possibili classi binarie si procede così:

- La probabilità della classe 1 è direttamente (è una mia scelta).

- Non esiste esplicitamente un : la probabilità della classe 0 è dedotta come complemento: .

- Analogamente per i target: .

Warning

In binary classification, there is only a single output neuron. However, the explicit formula for the loss in this context still contains two terms: one for the positive class and one for the negative class.

🎯 Why are there two terms?

Even though there is only one neuron producing the output , both possible binary classes are modeled as follows:

- The probability of class 1 is taken directly as (by convention).

- An output does not explicitly exist; the probability of class 0 is inferred as its complement: .

- The same logic applies to the target labels: .

Note

Nel caso binario, anche se l’uscita è unica, la loss tiene conto di entrambe le classi attraverso l’uso del complemento. rappresenta entrambi i contributi, pur derivando da un solo neurone.

Poiché, essendoci un solo neurone in uscita, , , allora:

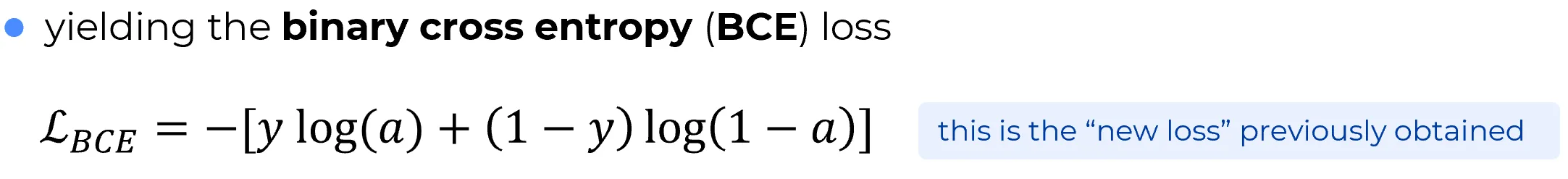

Due strade per arrivare alla Binary Cross-Entropy

| 🧠 Strada 1: Singolo neurone e analisi funzionale | 📚 Strada 2: Cross-entropy di Shannon istanziata |

|---|---|

| Si considera un singolo neurone sigmoide. Dal momento che l’uscita è interpretata come una probabilità, in quanto la funzione sigmoide restituisce valori in , il problema si configura naturalmente come una classificazione binaria. A partire da questo modello semplice, si imposta un problema di analisi funzionale. Da questa formulazione si perviene naturalmente alla binary cross-entropy loss. | Si parte dalla formula generale della cross-entropy di Shannon, definita tra due distribuzioni di probabilità. Istanziando il problema al caso di classificazione binaria — con una sola probabilità stimata e la complementare ricostruita — si arriva alla stessa espressione della binary cross-entropy loss. |

Entrambe le strade, pur partendo da approcci concettuali diversi, conducono naturalmente alla binary cross-entropy come funzione di costo per la classificazione binaria.