The Intuitive Argument

Example

A commonly proposed explanation for the preference toward small weights in neural networks is the following: smaller weights correspond, in a certain sense, to less complex models, which provide simpler and potentially more robust explanations of the observed data.

Consequently, such models should be preferred.

Questioning the Assumptions

Warning

This argument, although concise, contains several implicit assumptions that may appear controversial or unclear.

To analyze it critically, we start from a simple dataset and progressively build a model on top of it.

Goal of the Analysis

Goal

The objective is to understand whether and in what sense smaller weights can actually be associated with reduced model complexity and improved generalization ability.

Problem Setup

Setup

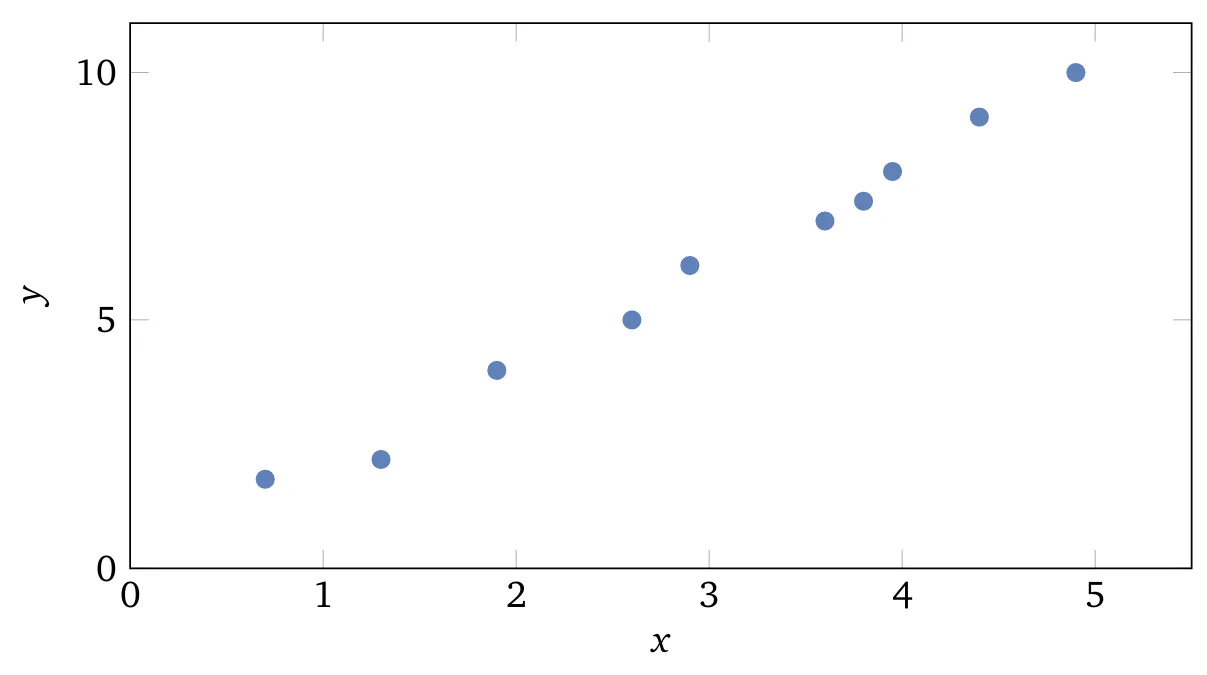

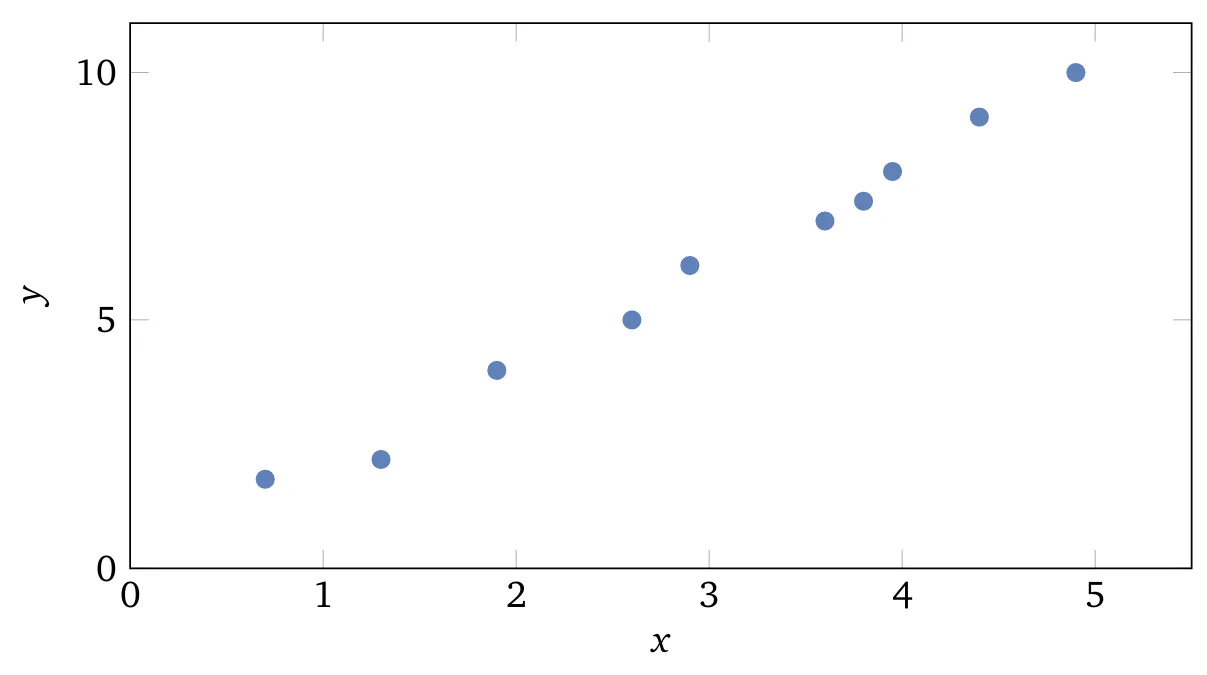

Assume we are studying a real-world phenomenon in which the variables and represent observable quantities.

The aim is to build a model that predicts as a function of .

Si assuma che si stia studiando un fenomeno reale, in cui le variabili e rappresentano dati osservabili del mondo reale.

Lo scopo è costruire un modello che permetta di predire come funzione di .

Sebbene si possa utilizzare una rete neurale per costruire tale modello, si considera qui un approccio ancora più semplice: modellare come un polinomio in funzione di . Tale scelta consente di rendere più trasparente il comportamento del modello e facilitare l’analisi. Compreso il caso polinomiale, sarà possibile estendere i concetti alle reti neurali.

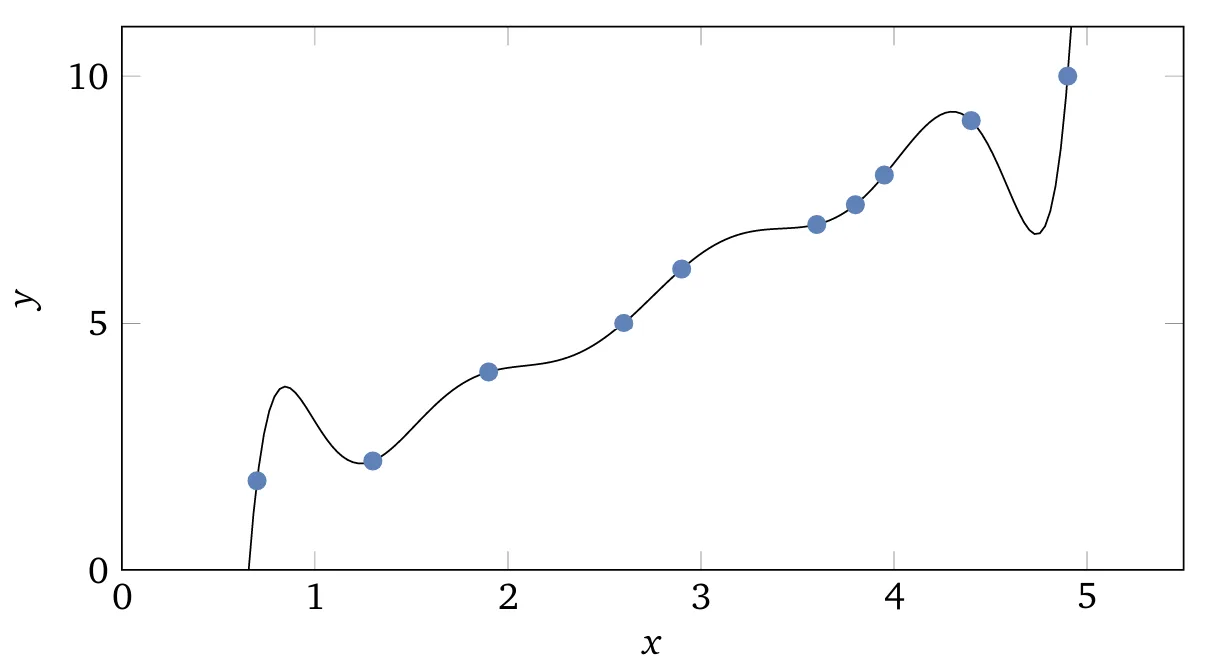

Nel grafico considerato sono presenti 10 punti. Questo implica che esiste un unico polinomio di ordine 9 della forma:

che interpolerà esattamente i dati osservati.

Confronto tra modelli: polinomiale vs lineare

| Polynomial model: | Linear model: |

|---|---|

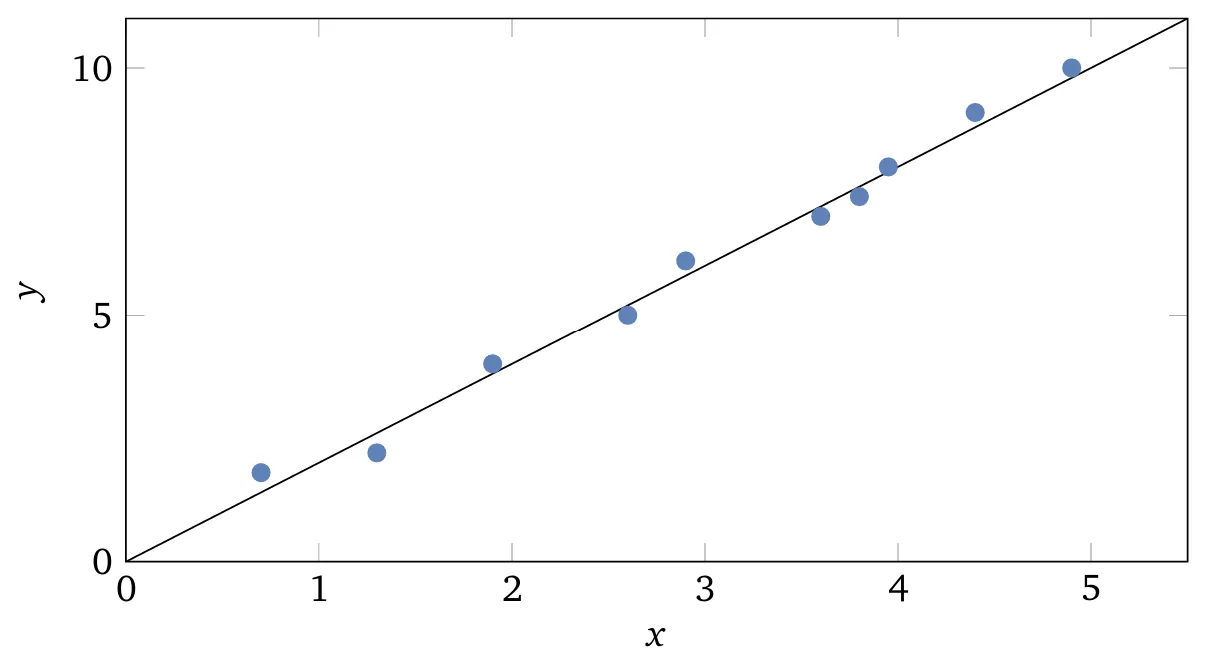

|  |

| Grafico del polinomio di grado che interpola esattamente i dieci punti considerati. Tale modello fornisce un’adattamento esatto ai dati. | Tuttavia, è possibile ottenere un buon fitting anche utilizzando un modello lineare del tipo . |

Questions

- Quale dei due è il modello migliore?

- Quale è più probabile che sia corretto?

- E quale dei due è più verosimile che generalizzi bene su nuovi esempi dello stesso fenomeno reale sottostante?

Key questions

- Which of the two is the better model?

- Which one is more likely to be accurate?

- Which of the two is more likely to generalize well to new examples of the same underlying real phenomenon?

Answer

In realtà, non è possibile determinare con certezza la risposta a nessuna di queste domande senza disporre di molte più informazioni sul fenomeno reale in esame.

Si possono però considerare due possibilità:

- Il polinomio di grado rappresenta effettivamente il modello corretto che descrive il fenomeno reale e, pertanto, generalizzerà perfettamente.

- Il modello corretto è , ma vi è un piccolo rumore addizionale, ad esempio dovuto a errori di misura, che spiega il motivo per cui il modello non si adatta perfettamente ai dati.

Non è possibile, a priori, stabilire quale delle due ipotesi sia corretta (né si può escludere che valga un’ulteriore ipotesi alternativa).

Dal punto di vista logico, entrambe le possibilità sono valide, e la distinzione non è banale.

È vero che, sui dati disponibili, la differenza tra i due modelli appare minima.

Tuttavia, supponendo di voler predire il valore di per un valore di molto più grande rispetto a quelli presenti nel grafico, emergerebbe una differenza marcata tra le due previsioni:

- Il modello polinomiale di 9º grado verrebbe dominato dal termine .

- Il modello lineare, invece, continuerebbe a crescere in modo lineare.

Questa divergenza evidenzia quanto la scelta del modello possa influenzare drasticamente il comportamento del sistema fuori dal dominio osservato.

Scegliere la spiegazione più semplice: una regola (quasi) universale?

Important

Un punto di vista comune nella scienza è che si debba preferire la spiegazione più semplice,

a meno che non vi siano motivi convincenti per fare altrimenti.Quando si individua un modello semplice che sembra spiegare bene molti punti dati, si è naturalmente portati a pensare di aver trovato qualcosa di significativo.

Dopotutto, sembra improbabile che una spiegazione semplice emerga per puro caso.

Piuttosto, si tende a sospettare che il modello stia catturando la struttura reale sottostante del fenomeno.Nel caso considerato, il modello appare molto più semplice rispetto a Sarebbe sorprendente se tale semplicità fosse emersa casualmente, e questo induce a sospettare che il modello esprima effettivamente una struttura reale del fenomeno osservato.

Da questa prospettiva, il modello polinomiale di 9º grado si limita in realtà a catturare gli effetti locali del rumore.

Pertanto, anche se tale modello si adatta perfettamente ai dati osservati, non sarà in grado di generalizzare bene su nuovi dati.

Al contrario, il modello lineare con rumore avrà maggiore capacità predittiva.

Il caso delle reti neurali

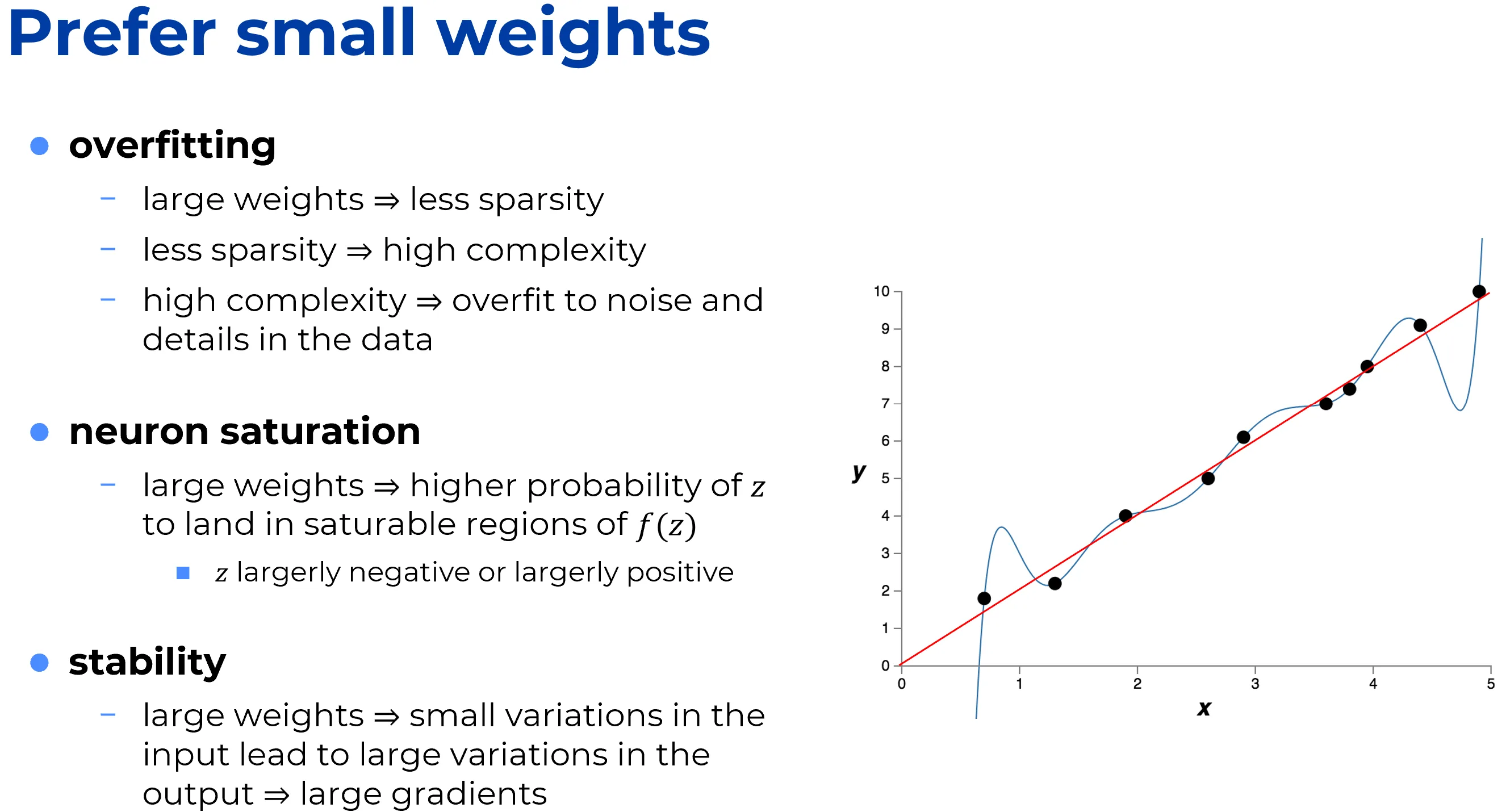

A partire dal punto di vista secondo cui si preferiscono modelli semplici, è utile considerare cosa questo implichi nel caso delle reti neurali.

Si supponga che una rete neurale abbia principalmente pesi piccoli, come tende ad accadere in presenza di regolarizzazione.

In tal caso, il comportamento della rete non cambia drasticamente anche se alcuni input vengono modificati in modo casuale.

Questo rende più difficile, per la rete, apprendere gli effetti del rumore locale nei dati.

In altre parole, la rete regolarizzata è meno sensibile a singole evidenze, e tende invece a rispondere a tipi di evidenze ricorrenti presenti nel set di addestramento.

Per contrasto, una rete non regolarizzata, con pesi elevati, può modificare notevolmente il proprio comportamento anche in risposta a piccole variazioni negli input.

Questo la rende capace di apprendere modelli più complessi, che però incorporano anche il rumore del training set.

In sintesi, una rete regolarizzata è vincolata a costruire modelli relativamente semplici, basati su pattern frequenti, ed è più resistente all’apprendimento delle irregolarità legate al rumore.

L’obiettivo è che la rete apprenda davvero il fenomeno sottostante, generalizzando meglio a partire da ciò che ha imparato.

Il limite del principio di semplicità ( Occam’s Razor)

Detto ciò, l’idea di preferire spiegazioni più semplici dovrebbe essere considerata con cautela.

Questa idea è spesso associata al cosiddetto “Rasoio di Occam” (Occam’s Razor), che viene talvolta applicato in modo eccessivamente rigido, quasi fosse un principio scientifico generale.

Tuttavia, non esiste alcuna ragione logica a priori per preferire una spiegazione semplice a una più complessa.

Anzi, in alcuni casi è proprio la spiegazione più complessa a risultare corretta.

Spesso la spiegazione più complessa è quella giusta: Einstein vs Newton 🪐

Nel 1859 l’astronomo Urbain Le Verrier osservò che l’orbita del pianeta Mercurio non coincideva esattamente con quanto previsto dalla teoria della gravitazione di Newton.

Si trattava di una deviazione minuscola, ma reale.Molte delle spiegazioni proposte all’epoca si basavano sull’idea che la teoria di Newton

fosse sostanzialmente corretta, ma necessitasse di una piccola modifica.Nel 1916, Einstein dimostrò che tale deviazione poteva essere spiegata in modo efficace

utilizzando la sua teoria della relatività generale, radicalmente diversa dalla gravità newtoniana e fondata su una matematica molto più complessa.Nonostante questa maggiore complessità, oggi è accettato che l’interpretazione di Einstein sia quella corretta, mentre la teoria di Newton, anche nelle sue versioni modificate, risulta errata.

Ciò è dovuto in parte al fatto che la teoria di Einstein spiega anche altri fenomeni che la teoria di Newton fatica a trattare, e soprattutto predice con precisione fenomeni che Newton non è nemmeno in grado di descrivere.

Tuttavia, queste qualità impressionanti non erano affatto ovvie all’inizio.

Se il giudizio fosse stato basato solo sul criterio della semplicità, una versione modificata della teoria di Newton sarebbe sembrata, con buona probabilità, più attraente.📌 Morale dell’esempio

- Stabilire quale tra due spiegazioni sia realmente “più semplice” può essere un compito sottile e complesso.

- Anche qualora si riesca a fare tale valutazione, la semplicità è un criterio che va usato con molta cautela.

- Il vero test di un modello non è la semplicità, ma la sua capacità di predire nuovi fenomeni in contesti non ancora osservati.

Conclusione

Remember

- La semplicità è un criterio utile, ma non assoluto.

- Deve essere usata con cautela, specialmente in domini complessi come il Machine Learning.

- L’evidenza empirica e la capacità predittiva su nuovi dati sono i veri indicatori della bontà di un modello.

Regolarizzazione: tra efficacia empirica e mistero teorico

Important

La regolarizzazione è un modo per ottenere pesi piccoli in una rete neurale

Una constatazione empirica

Important

È un fatto osservabile che le reti neurali regolarizzate tendono a generalizzare meglio rispetto a quelle non regolarizzate.

Per questo motivo, la regolarizzazione viene utilizzata frequentemente nella pratica, anche se la spiegazione teorica del perché funzioni non è ancora del tutto convincente.

Sulla ricerca attuale

La comunità scientifica continua a pubblicare lavori che confrontano vari approcci alla regolarizzazione, nel tentativo di capire quali funzionano meglio e perché.

La regolarizzazione, al momento, è vista più come un espediente pratico (kludge) che come una tecnica fondata su basi teoriche solide.

Ma cosa significa davvero generalizzare?

Il vero problema

Anche se la regolarizzazione migliora la generalizzazione, non spiega come funzioni realmente il processo di generalizzazione.

Questo tocca un punto cruciale nella scienza: come facciamo a generalizzare da pochi dati?

🧠 Il cervello umano come benchmark

Nella vita quotidiana, gli esseri umani generalizzano straordinariamente bene.

Basta mostrare a un bambino poche immagini di un elefante perché impari a riconoscerne altri.

Anche se può sbagliare (e.g. confondere un rinoceronte per un elefante), in generale il processo funziona sorprendentemente bene.

Important

Il cervello umano, con i suoi milioni di parametri, riesce a generalizzare anche da un solo esempio.

In un certo senso, il cervello realizza una regolarizzazione eccezionale.

Come riesce a farlo? Al momento non si sa con certezza.

🔍 Reti neurali: quando la rete non overfitta (ma dovrebbe)

Un caso concreto

Una rete neurale con 100 neuroni nascosti contiene quasi 80.000 parametri.

Eppure, con solo 50.000 immagini di training, riesce a generalizzare bene.

È come cercare di adattare un polinomio di grado 80.000 a 50.000 punti: ci si aspetterebbe overfitting estremo. E invece, in pratica, non succede.

Important

Una delle ipotesi più discusse è che la discesa del gradiente in reti multilayers abbia un effetto di “auto-regolarizzazione”.

È un fenomeno fortunato, ma anche inquietante: non è ancora chiaro perché accada.

✅ Approccio pragmatico

Practical tip

In attesa di una comprensione teorica più completa, l’approccio pragmatico è semplice: usare la regolarizzazione ogni volta che è possibile.

Le reti neurali ne beneficiano, anche se i motivi profondi non sono ancora chiari.

Problem Setup

Setup

Assume we are studying a real-world phenomenon in which the variables and represent observable quantities.

The aim is to build a model that predicts as a function of .

A Simpler Approach: Polynomial Models

Although one could use a neural network to model this relationship, here we adopt an even simpler approach:

modeling as a polynomial function of .

- This choice makes the model’s behavior more transparent.

- It also facilitates analysis.

- Once the polynomial case is understood, the concepts can then be extended to neural networks.

The Polynomial Interpolation Example

In the plot above, there are 10 data points.

This implies the existence of a unique polynomial of degree 9 of the form:

which will interpolate the observed data exactly.

Takeaway

Even with such a small dataset, the resulting model can already be highly complex (degree 9).

This sets the stage for analyzing the link between model complexity, parameter size, and generalization.