Intro

Utilizzare più dati è la soluzione migliore all’overfitting.

Purtroppo, poiché i dati a disposizione sono spesso limitati, un modo per “aumentarli” è generarli artificialmente, in modo dipendente dall’applicazione specifica. Tali dati generati artificialmente vengono poi forniti alla rete neurale durante l’addestramento.

Dati: l'ingrediente fondamentale del DL

Allo stato attuale, il successo del Deep Learning è fortemente determinato dalla quantità di dati disponibili.

Note

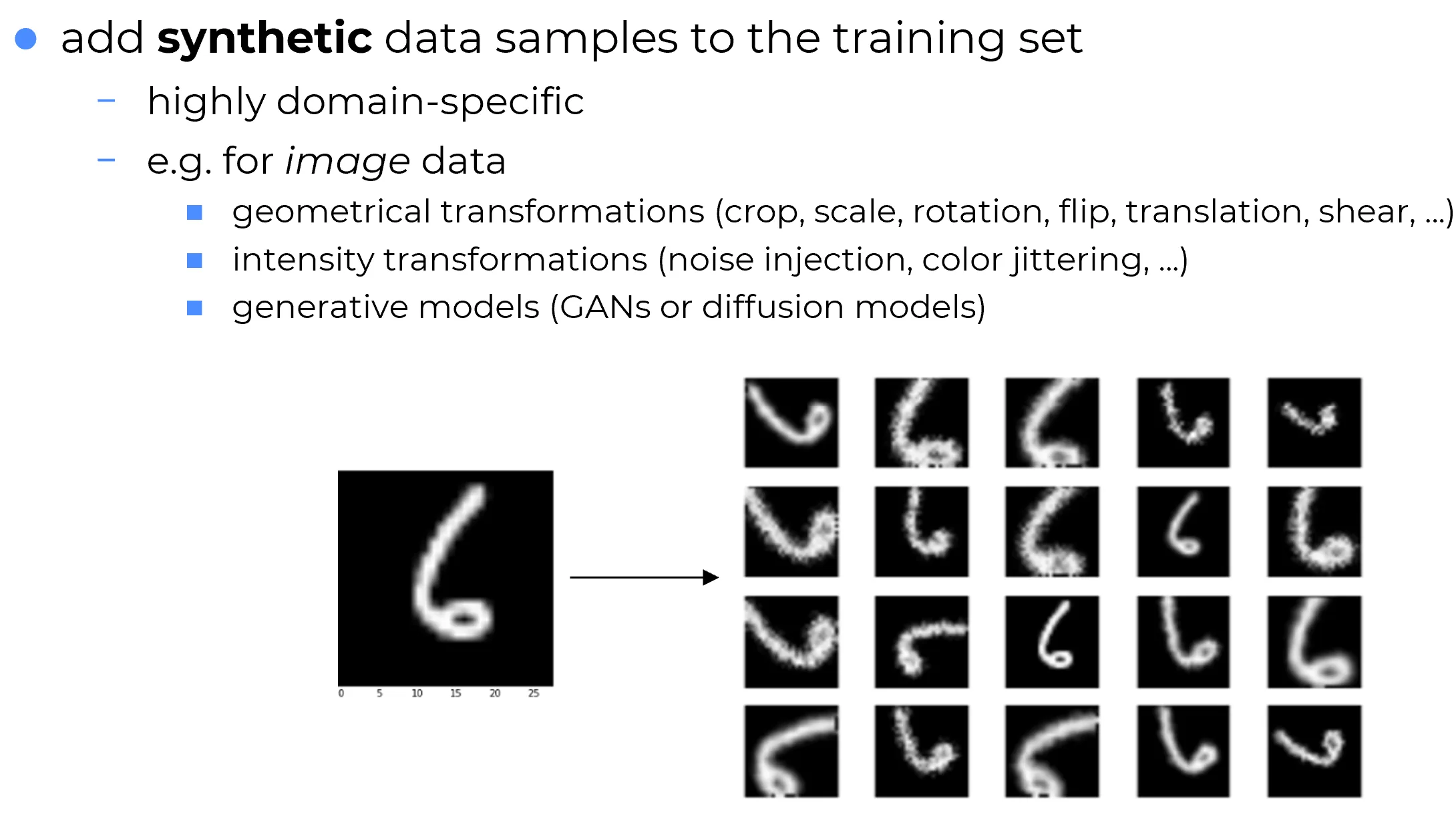

Esistono diversi approcci per generare più dati di addestramento, ma ciò che li accomuna è il fatto che sono fortemente specifici per il dominio di applicazione.

Se si considerano immagini, dal campo dell’elaborazione delle immagini (image processing) si sa che è possibile avvalersi di tecniche quali:

- Aumento del contrasto

- Equalizzazione

- Riduzione del rumore (denoising)

- Noise injection

- Trasformazioni geometriche

Tutti questi sono modi per generare nuove immagini a partire da quelle originali.

Important

Maggiore è l’eterogeneità introdotta dalla data augmentation, migliori potrebbero essere le capacità della rete neurale di generalizzare a dati mai visti prima.

Danger

Qualora tale tecnica fosse applicata in modo inappropriato, può introdurre distorsioni semantiche che inficiano l’addestramento del modello.

Data Augmentation e Ambiguità Semantica: il rischio di confondere il modello

La Regola d’Oro: Coerenza Semantica

Il principio fondamentale di ogni tecnica di data augmentation è che le trasformazioni non devono alterare il significato (la semantica) del dato. Un’immagine aumentata deve rimanere un esempio plausibile e corretto della sua classe.

Quando l'Augmentation è Dannosa

Se un’operazione introduce distorsioni non realistiche o cambia l’etichetta percepita, smette di essere un aiuto e diventa un ostacolo. Un esempio tipico è la rotazione delle immagini di risonanza magnetica cerebrale (MRI): poiché sono già allineate a uno standard, ruotarle non aggiunge informazione utile ma solo confusione.

Nella figura seguente, la soluzione proposta consiste nel generare varianti di un campione di addestramento (un’immagine di un numero scritto a mano proveniente dal dataset MNIST), in modo da costruire un dataset più eterogeneo.

Nel caso specifico di un’immagine del numero “6”, una rotazione estrema (ad esempio di 180°) trasforma il carattere in un’immagine che visivamente assomiglia a un “9”, pur mantenendo l’etichetta originale di “6”. Questo crea un conflitto fondamentale: il modello riceve segnali contraddittori tra la rappresentazione visiva modificata e l’etichetta invariata, con due possibili conseguenze critiche:

Danger

Scarso apprendimento durante il training:

La rete potrebbe non riuscire a identificare pattern coerenti a causa dell’elevato rumore introdotto dalle trasformazioni semanticamente errate. In questo caso, la loss sul training set non mostrerebbe il tipico decadimento esponenziale, indicando che il modello non sta generalizzando né apprendendo relazioni robuste.Worst case scenario: good training, atrocious inference

In uno scenario peggiore, il modello potrebbe “memorizzare” le trasformazioni artificiali invece di apprendere features discriminative. Nonostante una loss in training che diminuisce in modo ottimale, il modello fallirebbe clamorosamente sul test set, poiché la sua performance è legata ad artefatti introdotti dall’augmentation (es. angoli di rotazione specifici), non alla semantica reale dei dati. Il problema è insito nel fatto che in fase di training il modello è stato confuso dalle rotazioni che hanno stravolto la semantica dei dati di training. Quindi il modello ha memorizzando la tecnica di data augmentation usata.

Per evitare ciò, nel caso in esame, è cruciale definire intervalli di trasformazione semanticamente sicuri (es. rotazioni limitate a ±45° per caratteri numerici).

Note

In assenza di tali accorgimenti, la tecnica di data augmentation diventa un meccanismo che incoraggia l’overfitting (memorizzazione), vanificandone lo scopo originale (la mitigazione dello stesso).

Danger

Problem: it can easily backfire and lead to even mor eoverfitting

Le soluzioni presentate qui di seguito costituiscono linee guida di carattere generale—vere e proprie rule of thumb—e non devono essere seguite in modo rigido. Vanno intese come indicazioni di principio: se un modello non riesce a generalizzare nonostante l’applicazione di tecniche di data augmentation, è possibile che le trasformazioni adottate siano eccessive, oppure non significative e non rappresentative del dominio.

Un esempio tipico è la rotazione delle immagini di risonanza magnetica cerebrale (MRI): poiché queste immagini sono normalmente già registrate in un sistema di riferimento standard, ruotarle non aggiunge informazione utile e può addirittura introdurre confusione nel modello.

Important

In definitiva, ogni strategia di data augmentation và valutata caso per caso, alla luce dell’esperienza e della natura specifica del dominio applicativo.

🔴Not representative augmentation

Come discusso precedentemente, l’uso di trasformazioni non rappresentative può risultare controproducente: invece di aiutare la rete a generalizzare, può aggravare l’overfitting.

In particolare, l’uso di trasformazioni estreme — come rotazioni superiori ai 45° in task di OCR — può generare dati artificiali che non riflettono la distribuzione reale del problema.

Il modello, esposto a dati troppo eterogenei o semanticamente ambigui, può:

- fallire nell’apprendimento (loss alta e instabile), oppure

- apprendere pattern artefatti legati alle trasformazioni, ottenendo buone performance in training ma pessimi risultati in inferenza.

✅ Solution

Soluzione

La soluzione suggerita è adottare un approccio incrementale: iniziare con trasformazioni semplici e semanticamente “sicure”, per poi ampliare la varietà solo se necessario.

🔴Too much augmentation

La problematica riguarda la proporzione tra dati reali e dati aumentati.

Nel caso in cui il set di addestramento contenga solo l’1% di dati reali e il 99% di dati generati tramite data augmentation, l’intero processo di training risulterà dipendente dai dati sintetici.

Occorre prestare attenzione, poiché la rete neurale tende ad apprendere le specificità della tecnica di data augmentation utilizzata, soprattutto se la maggior parte degli esempi di training è sintetica.

- ✅ Se le trasformazioni applicate sono adeguate e rappresentative del dominio, il modello potrà apprendere pattern utili.

- ❌ Al contrario, qualora vengano introdotti esempi non realistici, la rete apprenderà da dati non validi, con il rischio di fallire completamente in fase di test su dati reali.

Addestrare una rete neurale è un arte più che scienza

L’addestramento di una rete neurale è spesso più simile a un processo empirico che a una procedura scientifica rigorosa.

Le strategie proposte vanno intese come principi generali: è l’esperienza applicativa che consente di determinare, caso per caso, le scelte più opportune.

Di conseguenza, non esiste una regola fissa secondo cui iniziare sempre con un rapporto 1:1 tra dati reali e aumentati e aumentare progressivamente.

💡 In certi contesti, ad esempio nel caso di immagini biomediche, può risultare più adeguato partire con un rapporto diverso (esempio reali vs artificiali), come 1:10, in funzione delle caratteristiche del dominio e della coerenza semantica dei dati.

🔴 Biased augmentation

Questo è un aspetto più sottile. La data augmentation distorta (biased augmentation) si verifica quando si applicano tecniche di aumento dei dati in modo diverso per classi differenti.

Qualunque operazione si compia sui dati di addestramento, se essa viene eseguita in modo differente a seconda della classe, la rete neurale — per sua natura un ottimo memorizzatore — se ne accorgerà.

In tal caso, anziché apprendere caratteristiche discriminative utili per distinguere tra le classi, la rete imparerà a differenziare le classi sulla base dei bias introdotti artificialmente nel processo di preparazione dei dati, compromettendo la generalizzazione e la validità del modello.

Questo fenomeno rientra in un problema più ampio legato alla data augmentation: se le trasformazioni applicate non rispettano criteri di coerenza e imparzialità tra le classi, si rischia di introdurre differenze artificiali che la rete neurale può interpretare erroneamente come elementi distintivi tra le classi, compromettendo così la qualità dell’apprendimento e la capacità di generalizzazione.