Problem statement

Si investiga ora un’altra causa del learning slowdown esibito dalle reti neurali.

In precedenza si è visto come si può agire sulla loss per mitigare il suddetto problema, mentre ora si indaga come si può agire all’interno della rete neurale per ottemperare allo stesso scopo.

Important

Il problema del learning slowdown declinato all’interno della rete è il fenomeno del vanishing gradient. Il fenomeno del vanishing gradient è imputabile all’applicazione della chain rule nella fase di back-propagation: ogni componente del gradiente risulta dal prodotto di molteplici termini parziali (derivate successive).

È sufficiente che anche uno solo di tali fattori assuma un valore molto prossimo allo zero affinché l’intera catena di prodotti, e dunque la corrispondente componente del gradiente, diventi trascurabile.

In assenza di una componente di gradiente di ampiezza adeguata, l’aggiornamento del parametro (peso o bias) corrispondente è di entità modesta e il processo di apprendimento rallenta.

Info

Tra le diverse limitazioni delle reti neurali, il vanishing gradient è certamente la più significativa.

Negli anni ’80 e ’90 tale fenomeno limitava fortemente la profondità delle reti addestrabili, impedendo di superare i 5 – 6 layer. Infatti, a ogni livello aggiuntivo, la back-propagation introduce un ulteriore termine moltiplicativo nella catena delle derivate, aumentando la probabilità del verificarsi del vanishing gradient, ostacolando l’apprendimento.

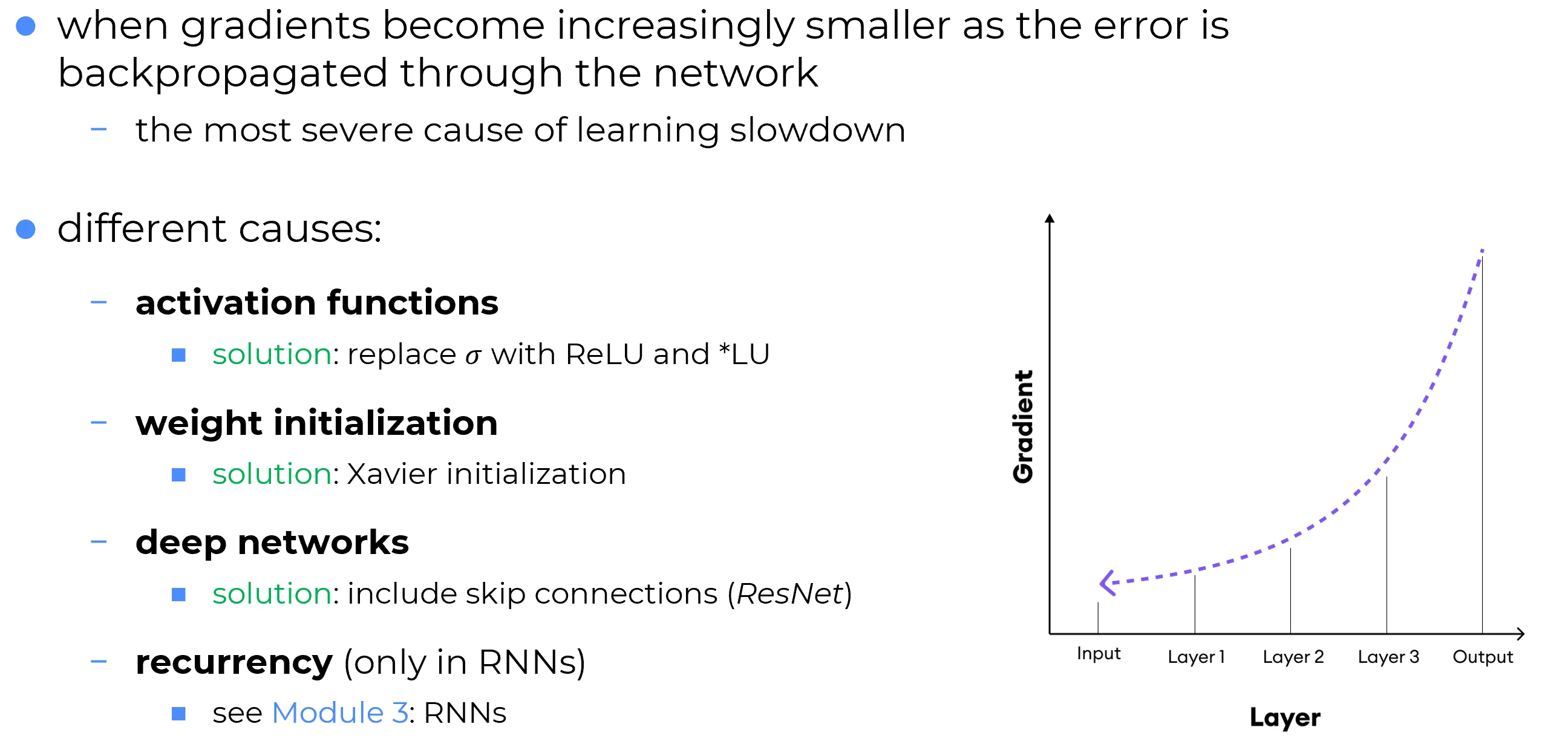

📈 Comportamento tipico del gradiente nella backpropagation

Nel grafico si osserva come il gradiente, partendo dai layer di output, tende progressivamente a ridursi man mano che si propaga a ritroso, da destra verso sinistra layer dopo layer verso l’input.

Questo fenomeno è dovuto all’effetto moltiplicativo reiterato delle derivate durante la backpropagation: ogni layer vede l’introduzione di un ulteriore termine moltiplicativo, il quale, se inferiore a , contribuisce a diminuire l’ampiezza del gradiente.

⚠️Conseguenza: i primi layer della rete — quelli più vicini ai dati di ingresso, cruciali per l’estrazione di feature di basso livello — apprendono molto più lentamente rispetto ai layer finali.

Ciò rappresenta un vero e proprio paradosso: i layer che dovrebbero costruire le rappresentazioni fondamentali dai dati grezzi sono i più penalizzati dal vanishing gradient.