Una delle cause del vanishing gradient è la saturazione del neurone.

Infatti, stante la , qualora l’input netto del neurone sia tale da saturare il neurone, ossia cada nelle regioni estreme della funzione di attivazione dove , la componente del gradiente relativa ai parametri di quel neurone si pressoché annulla (), contribuendo al fenomeno del vanishing gradient.

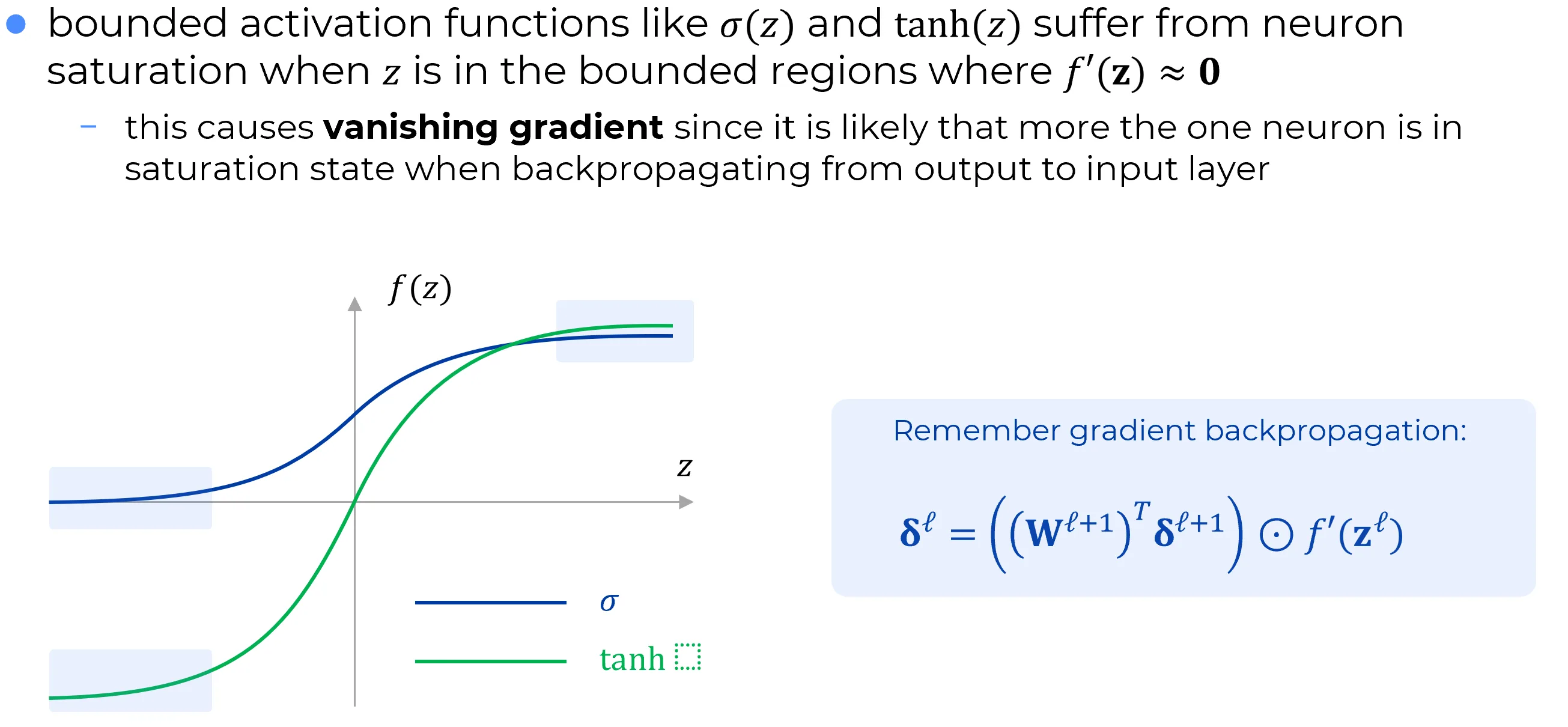

Le funzioni di attivazione limitate, come la sigmoide e la tangente iperbolica ,

soffrono del problema della saturazione dei neuroni allorché l’input cada nelle regioni dei rispettivi domini dove .

La peculiarità della tangente iperbolica è di esibire una derivata più steep rispetto a quella della sigmoide, il che si traduce in una maggiore sensibilità ai cambiamenti dell’input nella regione centrale.

Tuttavia, essendo comunque una funzione limitata, anche la soffre di saturazione

quando assume valori molto positivi o molto negativi, portando nuovamente a

e, di conseguenza, al rischio di vanishing gradient.