Goal: Ponderazione Automatica del Contesto

In continuità con la chiosa della nota precedente, si palesa l’esigenza di un meccanismo capace di discriminare tra gli elementi di una sequenza, assegnando a ciascuno un peso commisurato alla sua effettiva rilevanza per il task da svolgere.

Tale processo di discriminazione deve, naturalmente, essere interamente automatico perché destinato a operare in fase di inferenza, ovvero quando non è più possibile l’intervento di un operatore umano che possa indicare manualmente le parole più salienti all’interno della frase (nel caso di studio in esame, il tweet).

Attention Mechanism

La soluzione a questa esigenza è rappresentata dal meccanismo attenzionale (attention mechanism), che verrà qui introdotto nella sua forma più basilare, una sorta di “Hello, World” o “versione 1.0” del concetto.

Soft Attention: hello world of attention mechanism

SOFT ATTENTION (Attention Mechanism version 1.0)

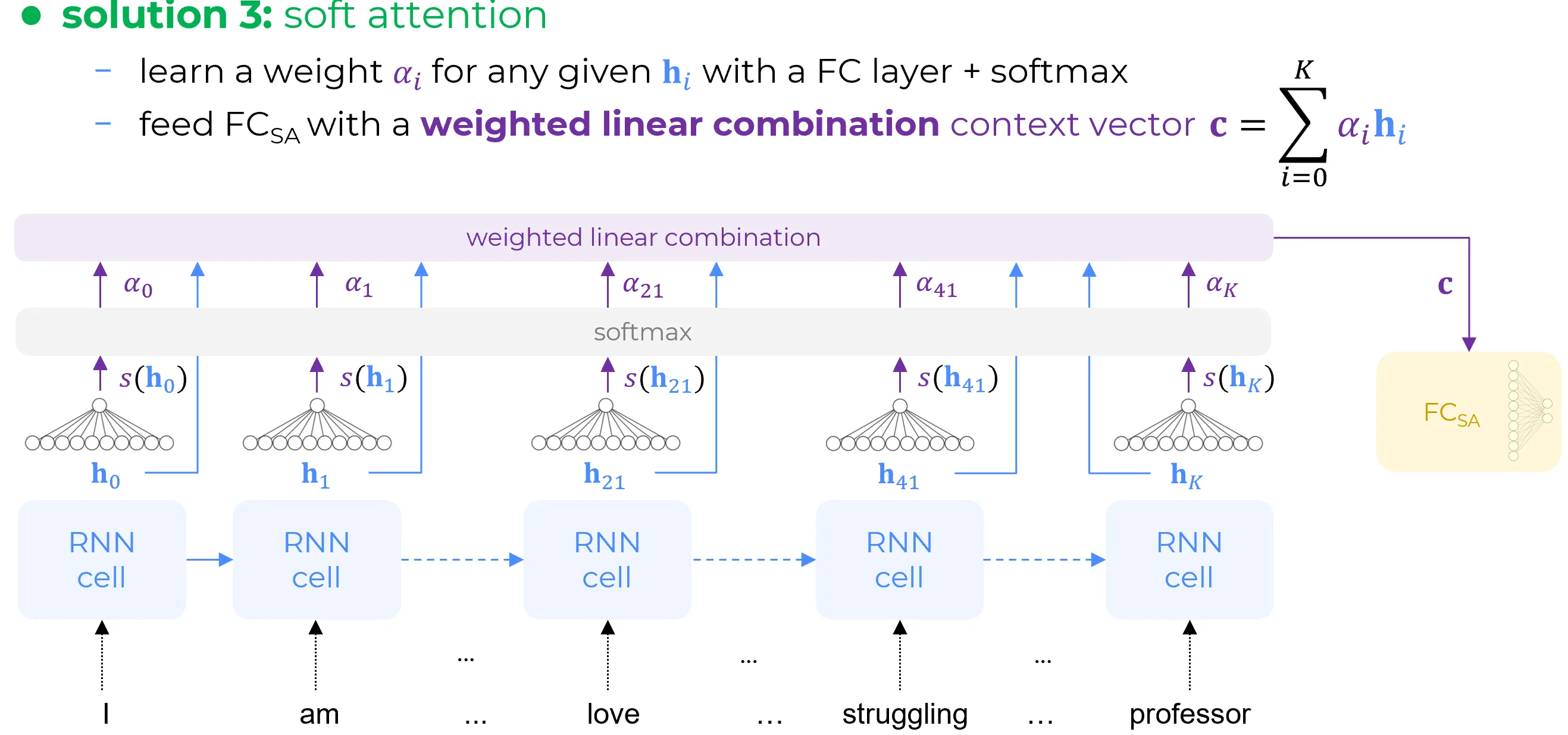

Il meccanismo di attenzione esplica il suo funzionamento attraverso la seguente sequenza di operazioni:

- si fornisce ciascun vettore di stato nascosto in input a una rete Fully Connected (FC) di dimensioni estremamente ridotte (stante il suo compito, ovvero mappare un vettore multidimensionale a un singolo valore scalare, di fatto, è la più piccola possibile).

- Tale rete mappa ogni vettore di stato nascosto ad un punteggio attenzionale (attention score) scalare .

- Successivamente, una funzione softmax converte tali punteggi in una distribuzione di pesi la cui somma è pari a , .

- Tali coefficienti , che rappresentano i punteggi attenzionali normalizzati nell’intervallo , vengono quindi impiegati per pesare i rispettivi vettori di stato nascosto , calcolando una media pesata che produce il vettore di contesto finale

\mathbf{c} = \sum_{i=0}^{K} \alpha_{i} \mathbf{h}_{i}

undefined