L’analisi delle problematiche inerenti alle Reti Neurali Ricorrenti (RNN) non può prescindere da una disamina del contesto storico-scientifico degli anni Novanta. In tale scenario, il problema del gradiente evanescente rappresentava un ostacolo di primaria importanza. In quel periodo, infatti, non erano ancora stati concepiti gli strumenti architetturali idonei a mitigare tale fenomeno, quali, ad esempio, le connessioni residue (skip connections).

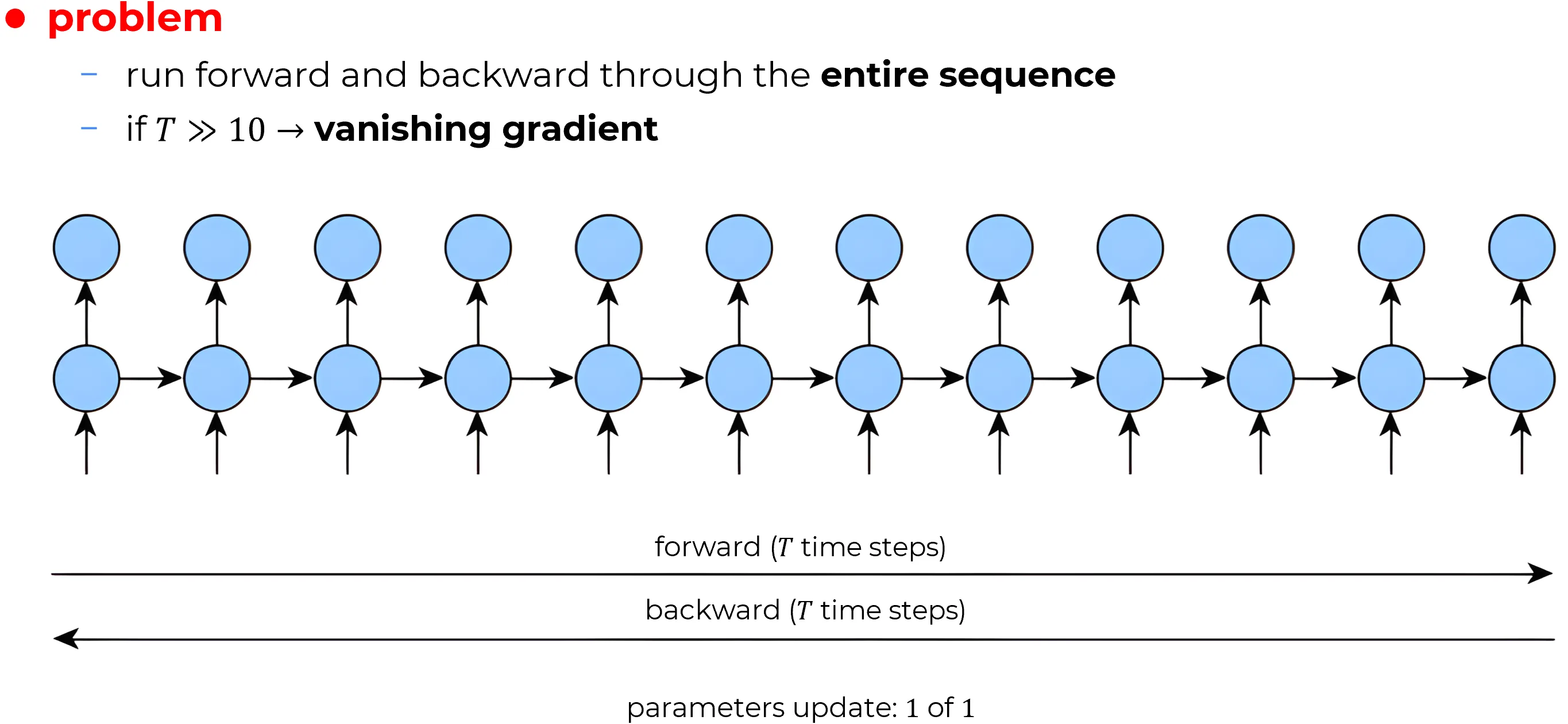

Let be the length of the unrolled RNN layer through time (it’s an hyperparameter) , then even with T=50, T=100 will cause vanishing gradient.

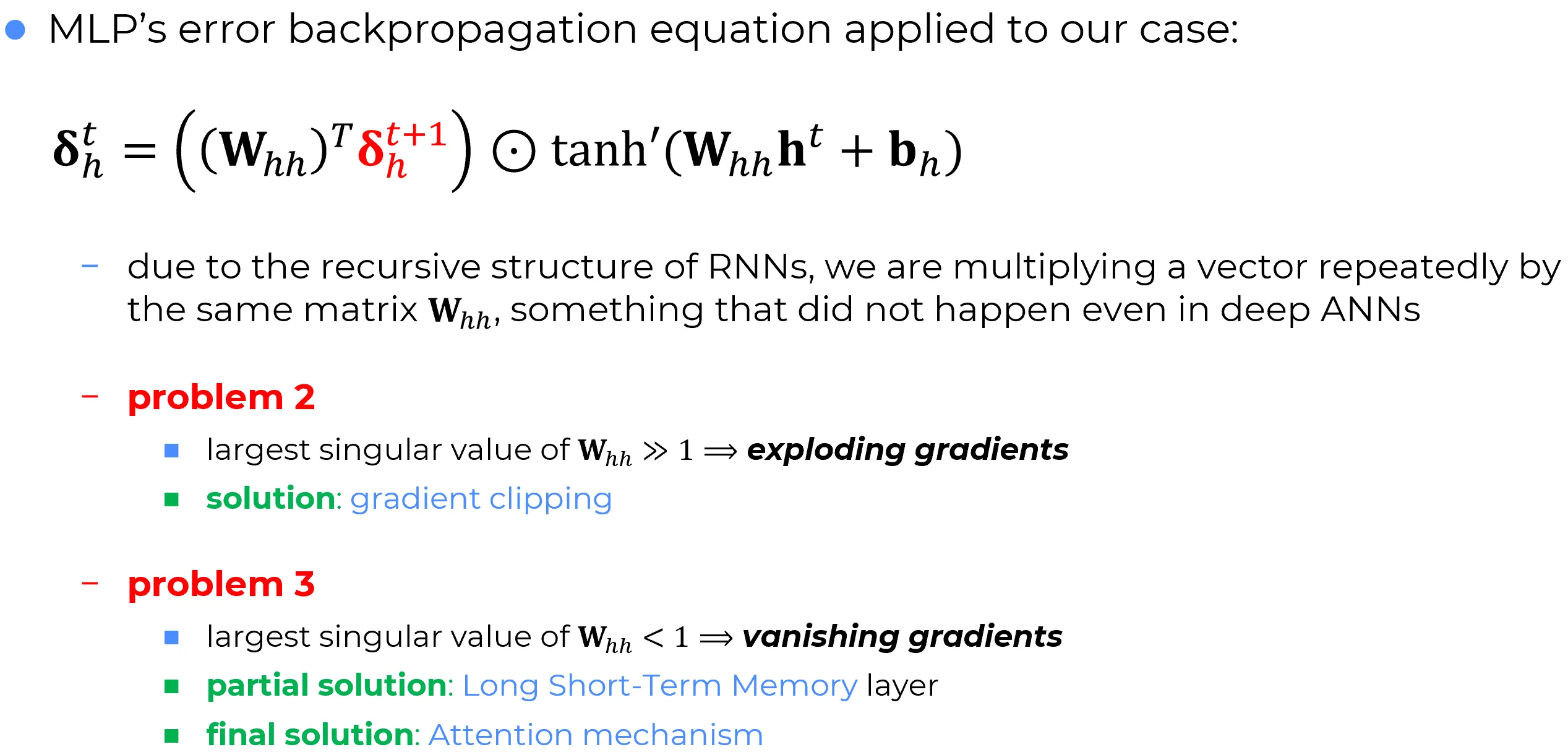

Root cause of vanishing gradient in RNNs